Note de service : faire une blague à base de « ma résolution pour 2012 c’est du 1 024 x 768 », c’est interdit.

D’une part, nous ne sommes plus en 2001 : mes écrans travaillent en 1 680 x 1 050, 1 920 x 1 200 et 1 600 x 1 024 (et bientôt 2 560 x 1 440). Le 1 024 x 768, c’est votre antique iBook ou votre vieil écran de 15 pouces il y a (très) longtemps.

Ensuite, 1 024 x 768, c’est une définition, pas une résolution.

La définition, c’est le nombre de points de l’image, 1 024 x 768 par exemple. C’est indépendant de la taille de l’écran. C’est pour ça qu’on parle d’un téléviseur HD pour Haute Définition. Qu’il fasse 32 pouces ou 55 pouces, ça reste du 1 920 x 1 080.

La résolution, c’est le nombre de points par pouce carré (par exemple). C’est donc dépendant de la taille physique de l’écran. Un 32 pouces en Full HD, c’est 68 ppp (ou dpi). Un 55 pouces, c’est (seulement) 40 dpi. Un écran d’ordinateur, c’est généralement entre 100 et 133 dpi (rarement plus, rarement moins).

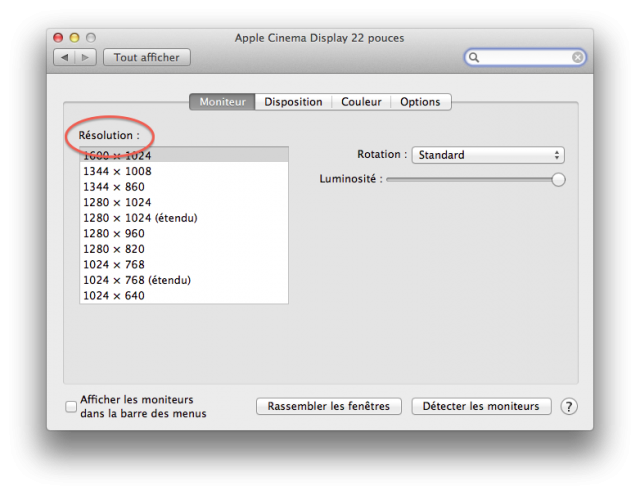

Comme on me le fait remarquer, Windows (et Mac OS X) n’utilisent pas le bon terme. Ce n’est pas une raison : c’est faux. C’est comme les Mo de Windows qui sont en fait des Mio.

C’est peut-être Windows qu’il faut blamer pour cette confusion de vocabulaire… http://img18.imageshack.us/img18/5272/resolutionx.png

La langue française évolue, si tout le monde dit résolution pour définition, alors les deux termes peuvent s’inversationner (si si, on dira comme ça dans les années 2700), c’est à l’Academy Française (si si, on dira comme ça quand Nikos Aliagas sera Président de la République) de s’adapter.

Même les boutiques se trompent !

http://bit.ly/thundisp1

http://bit.ly/thundisp2

:)

(et ils ne donnent pas la résolution !)

Une petite chose que je ne comprend pas :

si on parle de dpi ou ppp, c’est bien pour s’affranchir de la taille de l’écran puisqu’on parle PAR pouce carré.

Un peu comme les kilomètres PAR heure, on peut comparer les vitesses, que l’on fasse 100 ou 300 km dans la journée…

…non ?

Oui et non. Ca permet juste de comparer la taille des caractères sur un écran, regardé à la même distance.

Après, on sait qu’un écran de 55 pouces, ben on aura plus de recul qu’un 22 pouces.

???

Lapin compris… ^^

Les dpi ne servent pas à s’affranchir de la taille de l’écran, c’est une donnée supplémentaire. Donner des dpi sans la taille de l’écran en plus, c’est d’ailleurs un peu inutile.