Si vous avez lu le Canard PC Hardware n°23, vous avez lu mon test de l’iMac 5K.

On va faire simple : avec la carte graphique de base, la machine rame. Le GPU (pourtant plus rapide que prévu) a vraiment du mal avec la définition de l’écran, ou plus exactement avec le mode Retina. La vidéo le montre bien (en 60 fps sous Yosemite…), ça rame.

Je ne me suis pas étendu sur ça dans le magazine, mais il y a quelques points intéressants. Si vous jouez avec RDM (un petit soft qui permet d’accéder à différentes définition) ou SwitchResX (la même en chose en plus complet), on peut afficher la définition native (5 120 x 2 880) et même plus, avec du 6 400 x 3 600. Ce mode permet d’afficher énormément d’informations (même si c’est totalement illisible) et, assez étonnamment, est plus rapide que du 1440p Retina.

Les outils de Mac OS X (comme Quartz Debug) confirment : l’interface est plus rapide quand on ne redimensionne pas, indépendamment de la définition. Le chargement d’une interface doublée et les traitements liés semblent avoir un impact sur les performances. Plus simplement, c’est plus rapide en 5 120 x 2 880 qu’en 2 560 x 1 440 Retina (et donc calculé en 5 120 x 2 880).

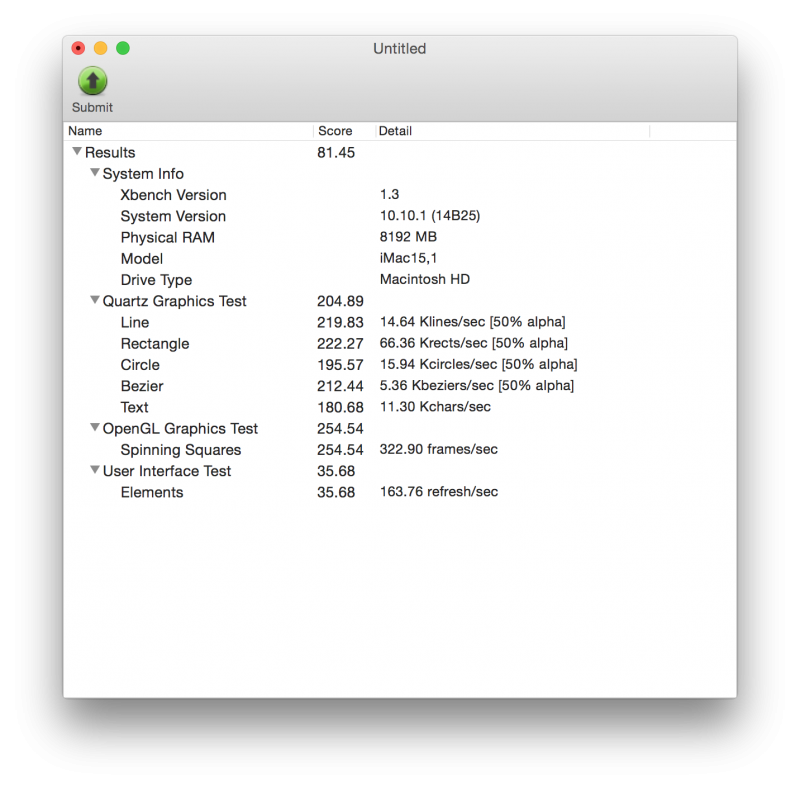

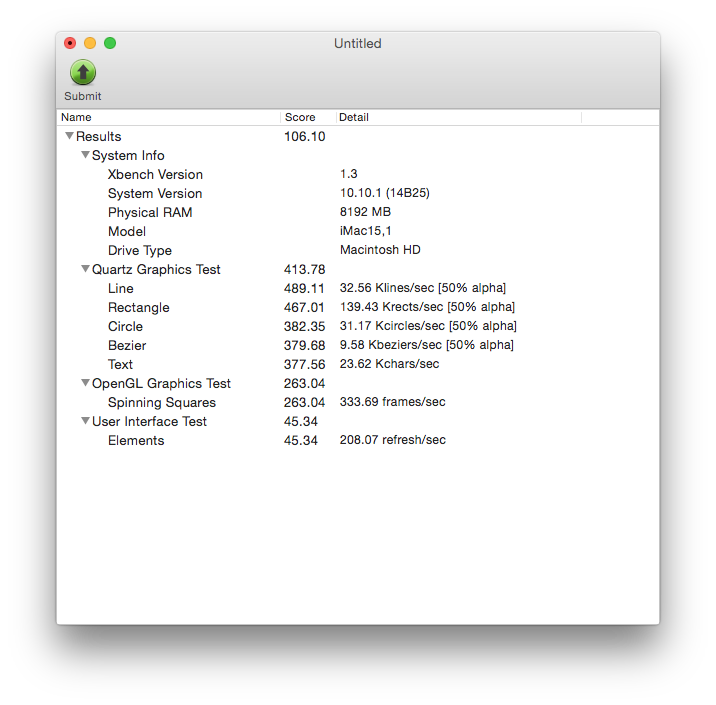

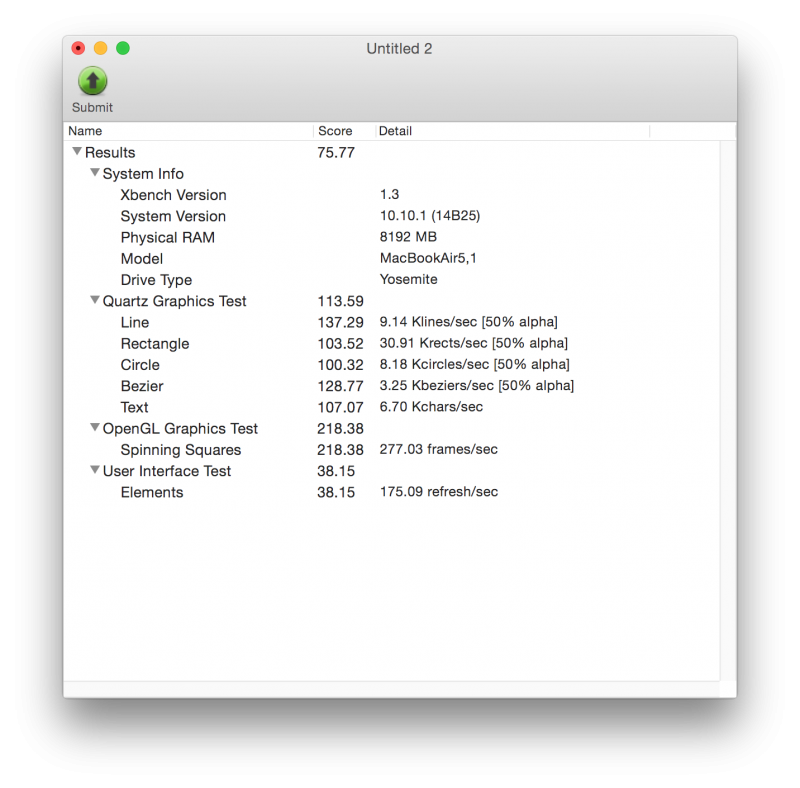

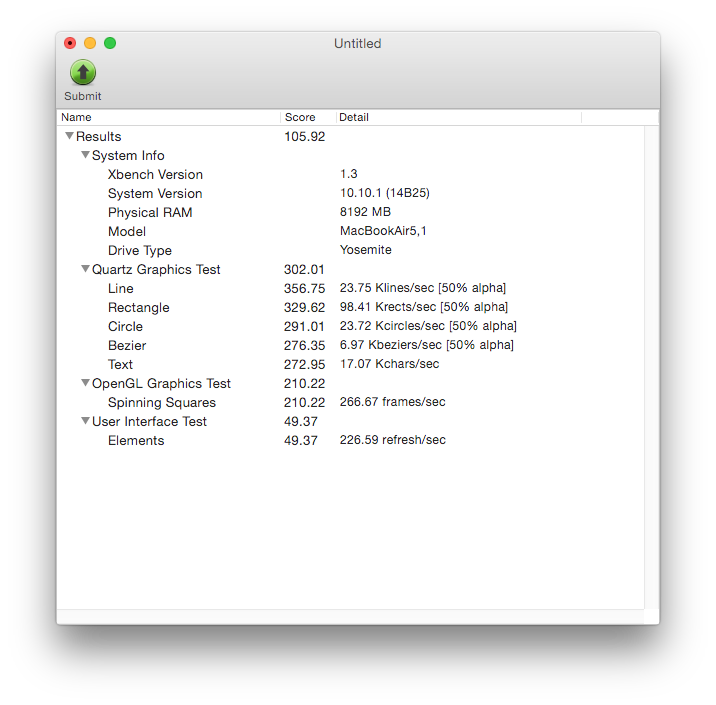

Le vieux test Xbench le montre bien, et pas uniquement sur un iMac Retina. Les tests graphiques, qui font appels aux API de Mac OS X, sont plus rapide sans le redimensionnement Retina à définition identique, très nettement sur certains points.

Tout ce qui est lié à Quartz est franchement plus lent, ce qui explique en partie que la machine est lente sur certaines actions basiques de l’interface de Mac OS X.

C’est une simple constatation : le passage en Retina diminue les performances. Ce n’est pas un problème sur les MacBook Pro Retina, mais ça l’est sur un iMac 5K, pour une raison : il y a bien plus de pixels à traiter. Pour des raisons que je ne connais pas, Apple utilise des cartes graphiques AMD, et le modèle d’entrée de game, la R9 290MX, n’est pas adapté. Je n’ai pas testé le modèle plus haut de gamme (équipé d’une R9 295MX) mais c’est visiblement moins problématique. Au passage, les utilisateurs de Mac Pro vont devoir se méfier : la carte D300 utilisée dans le modèle le moins cher est la soeur jumelle de la carte de l’iMac 5K.

Apple va peut-être régler le souci, mais étant donné que d’autres machines souffrent des mêmes pertes de performances, ce n’est pas lié directement à l’iMac Retina, donc je ne pense pas que ça va être corrigé. Idéalement, il faudrait une carte graphique plus puissante et qui consomme peu, ce que nVidia propose dans le monde mobile avec ses cartes Maxwell. En attendant, si vous avez vraiment besoin d’un iMac, la carte graphique optionnelle est plus qu’indispensable. Je rappelle aussi que les iMac ont très souvent des soucis de surchauffe du GPU et qu’une carte sous-dimensionnée peut vraiment poser des soucis sur ce point.

La vidéo montre seulement l’entrée et sortie de Mission Control. Si c’est la seule manifestation de lenteur, c’est visiblement un souci général et uniquement software. Voir https://discussions.apple.com/message/26931558#26931558.

C’est pas la seule, c’est juste symptomatique et simple à montrer.

Globalement, toutes les taches qui utilisent le GPU sont pas très rapides, en tout cas indigne d’une machine de ce prix.

le problème ne viendrait pas aussi des pilotes graphiques, souvent à la ramasse chez Apple ?

Depuis Yosemite mon mbp 13″ 2010 est limite sans écran externe (1080p) et inutilisable avec.

J’ai réglé le problème en désactivant la transparence de l’interface. Ça tourne de nouveau correctement et j’ai même certains softs et jeux qui tournent mieux que sous Mavericks. (Pixelmator et Diablo 3, surtout. Il est possible cependant que ce soit la « faute » des soft).

Au niveau des effets de transparence et de blur ce n’est pas la taille de la surface à calculer qui est en cause mais sa densité. Dans la mesure où OSX change la densité de l’écran en mode retina et non pas la taille de l’affichage c’est un rien plus complexe à calculer.

Les API graphiques d’OSX expriment les coordonnées en points. 1 point = 1 pixel dans le mode non retina uniquement, sinon 1 point = 4 pixels par exemple mais on peut représenter plus de détails qu’il faudra bien entendu calculer.

Il ne faut alors pas faire l’erreur de penser qu’on va simplement remplacer un pixel par un lot de 4 en retina. (https://developer.apple.com/library/mac/documentation/GraphicsAnimation/Conceptual/HighResolutionOSX/Introduction/Introduction.html explique tout ça très bien)

Pour résumer si on prend l’effet blur qui est calculé pour chaque pixel à partir de ses n voisins proches (n varie de 1 à… plus que 1) le blur en retina demande 4 fois plus de calculs.

Mais Yosemite est comme Jonathan Ive : il aime le blur.

C’est pourquoi, je pense, qu’il serait intéressant de refaire ces tests sans la transparence. Même si le retina demandera toujours plus de calculs. Apple devrait être honteux de vendre une machine inadaptée à l’exercice à un tel prix.

YOSEMITE C’EST DU CACA VOILA TOUT :)

Merci Apple de sortir des OS toujours plus à ch*er :)