Il y a de longues (longues) années, j’avais essayé un produit intéressant : un disque dur hybride, qui intégrait un SSD. Le WD Black² n’était pas une sorte de compromis comme pas mal de SSHD de l’époque, qui utilisaient quelques Go de mémoire flash comme mémoire cache. Non, il intégrait réellement un SSD classique (120 Go) et un HDD (1 To). Mais à l’époque, il n’était pas compatible avec Mac OS X.

Je l’avais testé fin 2013 et WD a attendu plusieurs mois (juillet 2014) pour proposer une compatibilité avec Mac OS X (je ne l’avais plus à l’époque, c’était un prêt). Le fonctionnement, même si le disque contient deux périphériques, est un peu particulier. Par défaut, l’OS risque de ne voir que le SSD, qui a une capacité de 120 Go. Il est basé sur un contrôleur JMicron de l’époque (667H) et ce n’est pas le plus rapide du monde. S’il est bien SATA 6 Gb/s, il ne dépasse pas 400 Mo/s en lecture, une limite commune aux modèles de l’époque. En écriture, il reste lent (environ 140 Mo/s). Le disque dur, lui, est un WD Blue de 1 To, qui tourne à 5 400 tpm, rien de fou.

Il est joli

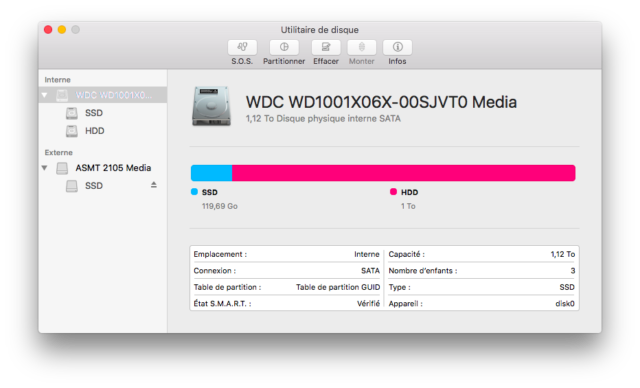

J’avais testé sous Mac OS X sans succès à l’époque. Comme c’est expliqué sur ce post, WD utilisait une technique bizarre : des commandes envoyées au disque permettaient de le configurer comme un disque de ~1120 Go (HDD + SSD) avec deux volumes distincts, un pour le SSD et un pour le HDD. La compatibilité Mac OS X officielle fonctionne de cette façon : l’OS voit un seul disque. La marque avait tout de même bien fait les choses : l’outil (on en parle dans la suite) permet de créer soit deux volumes séparés, soit un Fusion Drive directement.

Testons

J’ai pris un vieux MacBook (2008) pour tester. Ce n’est pas forcément la machine la plus adaptée, vu qu’il n’est que SATA 3 Gb/s, mais la machine était équipée d’un vieux SSD de 120 Go et elle a du SATA. Le WD Black² n’est en effet pas adapté aux ordinateurs récents (surtout les Mac) qui abandonnent peu à peu cette interface.

La première étape va être d’installer le WD Black² en interne. Il faut donc prévoir de quoi démarrer le disque d’origine en externe (WD livrait un adaptateur USB à l’époque) ainsi qu’une clé USB. Il faut deux outils disponibles sur le site de la marque : la mise à jour de firmware et les outils de configuration. La procédure est bien expliquée sur le site de WD, même si les captures datent un peu (c’est ou l’évolution visuelle de macOS en quelques années).

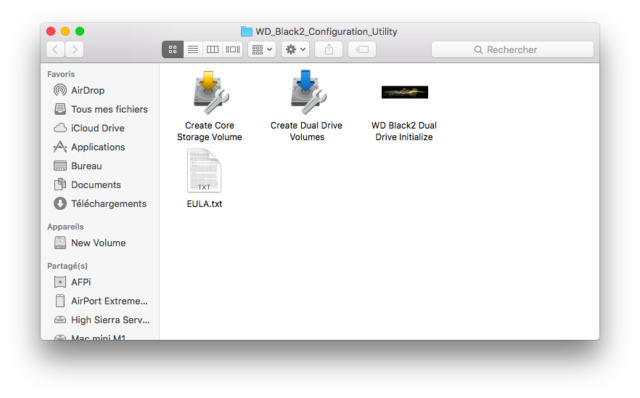

Les outils d’initialisation

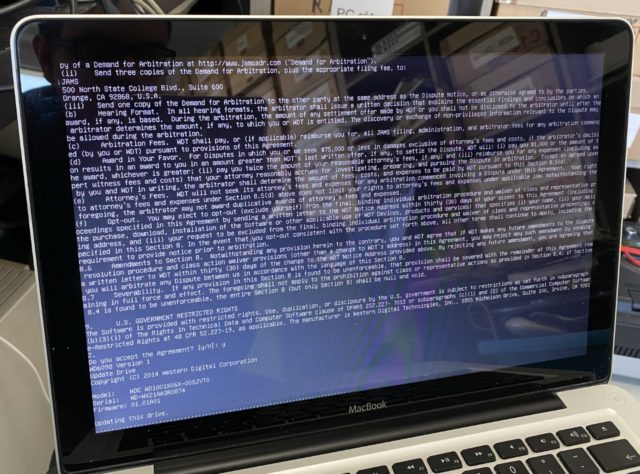

Première étape, donc, démarrer Mac OS X (ici El Capitan) en externe, en USB 2.0. Il faut ensuite restaurer la mise à jour de firmware (qui fonctionne sous Linux) avec l’Utilitaire de disques sur la clé USB et démarrer dessus. C’est bien expliqué dans le PDF, je ne vais pas détailler. Une fois l’image sur la clé USB, il faut démarrer dessus (le volume s’appelle EFI Boot) et laisser la mise à jour s’effectuer. Ca démarre sous Linux avec pleins de textes, il faut accepter la licence et attendre quelques minutes que la mise à jour s’effectue, vers la version 01.01A02. Quand il a terminé, le Mac s’éteint.

Mise à jour en cours

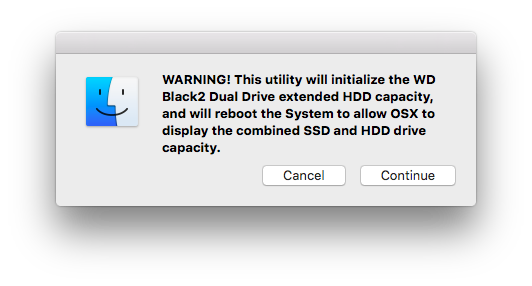

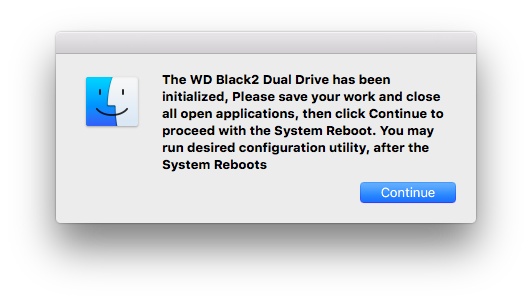

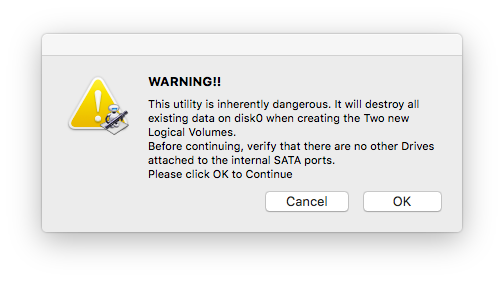

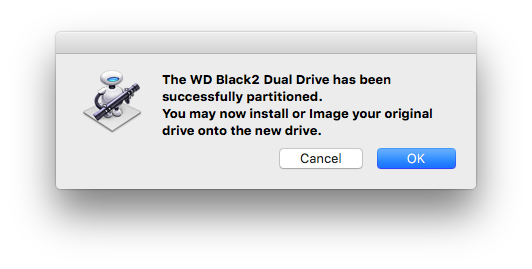

Ensuite, il faut encore démarrer Mac OS X en externe et lancer le script d’initialisation (WD Black2 Dual Drive Initialize). Il va configurer le disque et (encore) redémarrer le Mac.

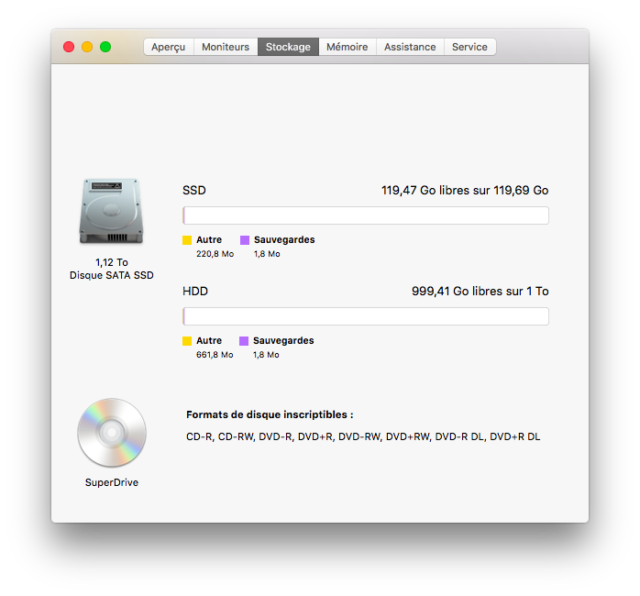

Pour tester, j’ai d’abord essayer de créer une double partition, avec le script Create Dual Drive Volumes. On se retrouve avec un volume HDD de 1 To et un volume SSD de 120 Go, avec les bonnes performances. Sur le MacBook de 2008, environ 130 Mo en écriture et 250 Mo/s en lecture sur le SSD (la limite du SATA 3 Gb/s) et 110 Mo/s sur le disque dur.

Deux volumes

Deux volumes

Les performances du SSD

Celles du HDD

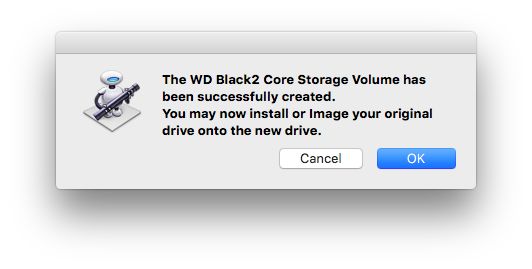

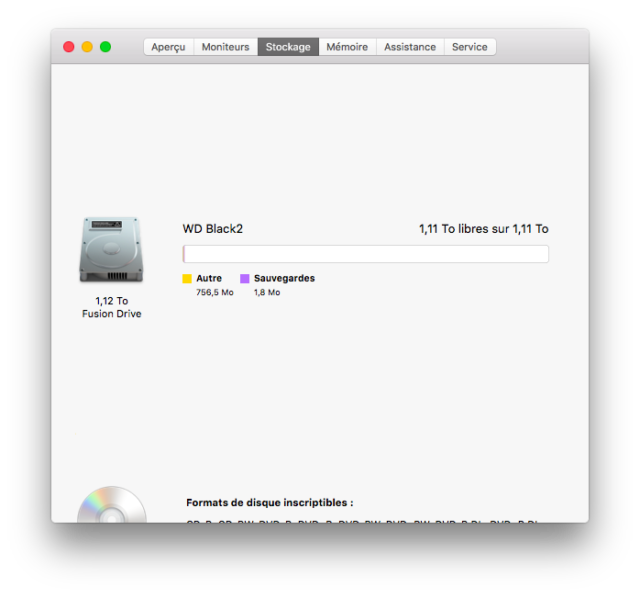

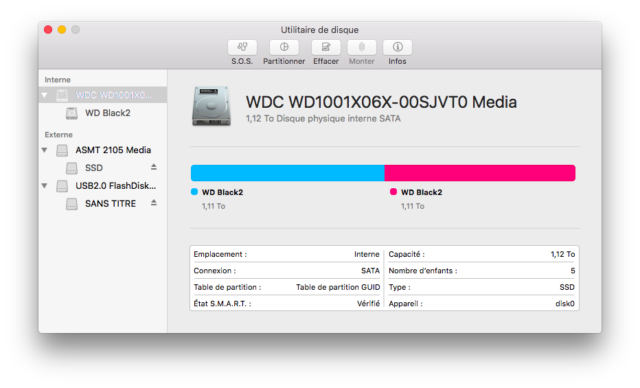

Puis j’ai lancé le second script, qui va créer un Fusion Drive (Create Core Storage Volume). La, on se retrouve avec un volume de 1,12 To, combinés. On a les performances du SSD (une partie du temps) avec la capacité de l’ensemble.

Un seul volume

Un seul volume

La dernière étape va être de réinstaller Mac OS X sur le WD Black² et on touche à un souci de la solution : on perd la partition de restauration. Il faut démarrer sur la partition de restauration du disque d’origine (toujours en externe) et restaurer Mac OS X sur le WD Black². Mais pour éviter de casser le partitionnement très spécifique du WD Black², on ne peut restaurer que Mac OS X. Et sur un MacBook de 2008, c’est un souci en cas de problème : sur ce modèle, impossible de démarrer sur l’EFI. Il faut donc bien prévoir de soit garder le disque d’origine, soit avoir une clé USB avec les données nécessaires pour démarrer et tout recréer.

Mac OS X restauré

En dehors du fait que le WD Black² demandait quelques manipulations pour être fonctionnel (il doit aussi être initialisé sous Windows), son principal problème – même à l’époque – était son prix. Il valait environ 300 $ quand un SSD de 120 Go couplé à un disque dur de 1 To se négociait autour de 150 $. En 2021, la question ne se pose même plus : on trouve des SSD de 1 To à moins de 100 € en SATA. Le seul intérêt pratique, au moins en 2013/2014, c’était que le disque ne nécessitait qu’un seul emplacement SATA, ce qui le rendait intéressant dans les PC portables. Actuellement, avec les SSD en barrette, ce n’est plus un souci : en entrée de gamme, on a souvent une baie 2,5 pouces et du M.2, pour mettre un SSD d’entrée de gamme de 250 ou 500 Go, avec un HDD. Le WD Black² est surtout une curiosité ancrée dans son époque, et c’est déjà pas mal.

Je me suis toujours demandé à quel point ces SSHD pourraient être pertinents pour utiliser dans une TimeCapsule ?

J’en possède une « plate » avec un disque 3,5″ de TB, issu lui même d’un NAS grand publique « WD My Cloud ».

Est-ce que ça pourrait accélérer les sauvegardes/les lectures (dans le cadre d’une connexion en Ethernet ou en wifi 802.11 ac ?

Monté dans un NAS WD MyCloud (ethernet uniquement), ou bien dans le logement SATA d’une Livebox 4 d’orange (Sagemcom), est-ce que ça pourrait accélérer la lecture distante (depuis un iMac et/ou un MacBook) de bibliothèque iTunes ou Photos que l’on aurait déporté dessus ?

Ces équipements ne disposent que d’un seul port SATA, et y mettre un SSD serait selon moi « du gâchis », d’autant plus que le stockage de données tels qu’une bibliothèque Photos est plus fiable sur un disque à plateau.

Alors, le Black2, aucun intérêt et vu le fonctionnement, c’est compliqué, on doit pas pouvoir l’initialiser. Et il ne cache pas les données seul, donc on sauverait d’abord sur le SSD puis sur le HDD.

Les SSHD sortis à une époque avec un système de cache interne, je doute que ça serve. Le fonctionnement de base, c’est de copier les données utilisées dans la flash. Donc pour un usage purement sauvegarde, aucun intérêt (on accède rarement aux même données).

Pour un NAS avec des données fixes, genre iTunes ou Photos, oui, en théorie. Mais on gagnerait pas grand chose parce que dans le cas de la livebox ou d’un SSD bas de gamme, le facteur limitant est pas le disque lui-même mais l’appareil. Un « vrai » NAS améliorerait déjà les choses, en fait, et les modèles modernes proposent souvent de mettre un SSD comme cache, géré par l’OS du NAS.

Et la dernière phrase, je comprends pas bien : un disque à plateau est pas plus fiable qu’un SSD, c’est plutôt le contraire. Le SSD est pas spécialement indiqué pour du stockage à (très) long terme – genre 10 ans sans y toucher -, certes, mais c’est à peu près le seul défaut.

Merci pour la réponse complète

Et s’agissant de ma dernière phrase, je suggérai effectivement que les HDD étaient plus fiables, mais en fait après introspection, je voulais dire autre chose :

Que la récupération de données émanant d’un disque, défectueux certes, mais à plateau, était potentiellement plus réalisable qu’en provenance d’un SSD.

Je m’imagine qu’il « suffit » alors de monter les plateaux dans un HDD fonctionnel et roule !

Ce doit être légèrement plus compliqué.

Alors, pour les plateaux, c’était le cas y a 10 ou 15 ans, en remplaçant la carte électronique. C’est nettement moins possible actuellement, les plateaux et l’électronique sont souvent liés. Et sur les SSD, on a la même possibilité dans l’absolu, en mettant les puces de flash dans un lecteur dédié.

Mais dans les deux cas, c’est de toute façon probablement chiffré et illisible.